Eine neue haptische Technologie im Test

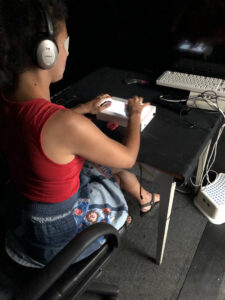

Photo: Laboratoire d’investigation neurophysiologique, Ruxandra Tivadar

Man stelle sich vor, dass man beim Berühren einer Bildschirmoberfläche Formen, Buchstaben oder Texturen wahrnehmen kann. Klingt noch nach Zukunftsmusik? Derzeit ist ein französisch-schweizerisches Forschungsprojekt im Gange, das sich genau diesem Thema widmet und zusammen mit einer Gruppe blinder und sehbehinderter Menschen eine bereits existierende haptische Technologie testet. Die Redaktion von tactuel wollte mehr darüber erfahren und hat sich mit drei Mitgliedern des Forschungsteams unterhalten, darunter Prof. Micah Murray, Leiter des neurophysiologischen Forschungslabors der Universität Lausanne, Ruxandra Tivadar, Doktorandin an der Universität Lausanne, und Dr. Olivier Lorentz, verantwortlich für den Bereich Innovation bei der Fondation Asile des aveugles.

Von Carol Lagrange

An einer Konferenz im Jahr 2015 hörte Olivier Lorentz zum ersten Mal von einer haptischen Technologie, die vom Start-up Hap2U in Grenoble entwickelt wurde. Diese patentierte Technologie soll zu besseren Erfahrungen in der digitalen Welt führen, indem der Tastsinn bei der Benutzung von Touchscreen-Geräten miteinbezogen wird. Zu diesem Zeitpunkt wurde die Technologie getestet in Bezug auf die Wahrnehmung von Texturen beim Online-Kleiderkauf oder im Zusammenhang mit dem taktilen Empfinden bei Videospielen. Olivier Lorentz fragte sich, ob diese Technologie nicht auch blinden und sehbehinderten Menschen nützlich sein könnte.

So wurde ein Forschungsteam gebildet, und es entstand eine Zusammenarbeit zwischen der Radiologieabteilung des Universitätsspitals des Kantons Waadt und der Universität Lausanne, der Fondation Asile des aveugles in Lausanne, dem französischen Unternehmen Hap2U sowie dem Forschungsinstitut Wirtschaftsinformatik der Fachhochschule Nordwestschweiz-Wallis in Siders. Unterstützt wird das Team vom Schweizerischen Nationalfonds, von der Fondation Asile des aveugles sowie von einem durch die Firma CARIGEST SA beratenen Mäzen. Ziel ist es, mittels einer digitalen taktilen Wahrnehmungsoberfläche vor dem geistigen Auge ein erkennbares Bild vom berührten Gegenstand zu erzeugen und damit die Erweiterung der Sinneswahrnehmung zu fördern.

Funktionsprinzip der Technologie

Gemäss Ruxandra Tivadar ist die Technologie derzeit noch in ein rechteckiges Gehäuse integriert. Es handelt sich dabei um eine Metallplatte, die feine Ultraschall-Vibrationen im Display erzeugt, wenn man mit dem Finger darüberfährt. Dabei werden durch Druckluft Erhebungen gebildet, die auf der Fingerkuppe für ein haptisches Feedback sorgen und Texturen fühlbar machen. Der Prototyp in Gehäuseform soll später durch eine kleine Platte abgelöst werden, in die die Technologie eingebaut ist und die bequem überallhin mitgenommen werden kann.

Anwendungsmöglichkeiten für blinde und sehbehinderte Menschen

Die Forscherinnen und Forscher sind dabei, die Technologie zusammen mit einer Gruppe blinder und sehbehinderter Menschen zu testen. Sie könnte diesen Menschen nämlich das Einprägen einer bestimmten Wegstrecke oder auch die räumliche Vorstellung stark erleichtern und es ihnen ermöglichen, geometrische Konzepte zu erfassen. An dreistündigen Einzelschulungen werden die sehbehinderten Personen von Ruxandra Tivadar im Umgang mit der Technologie vertraut gemacht. Diese Schulung beinhaltet auch eine Testphase, in der die ProbandInnen auf unterschiedliche Reize reagieren müssen. Damit will man herausfinden, welche Wirkung diese Navigation per Touchscreen hat. Bei blinden und sehbehinderten Menschen gibt es einen Bereich im visuellen Kortex, der nicht mehr aktiv ist. Man weiss nun aber, dass der visuelle Kortex über den Tastsinn aktiviert werden kann, sodass die betroffenen Personen wieder Buchstaben, Texturen und sogar Farben unterscheiden können.

Die taktile Wahrnehmung als sensorische Kompensation

Verliert ein Mensch seine Sehkraft, so wird diese bis zu einem gewissen Grad über den Gehörsinn kompensiert. Es existieren heute verschiedene Hörtechnologien, so Prof. Murray. Doch oft ist die sogenannte auditive Dekodierung sehr ermüdend und erfordert, dass die betroffene Person ihre ganze Aufmerksamkeit dem Dekodierungsprozess widmet und dabei nicht mehr auf die Klänge in der Umgebung achten kann. Dabei stellen die NutzerInnen der jeweiligen Technologie unter Umständen fest, dass sie nicht die volle Kontrolle über die dekodierten Informationen haben. Im Gegensatz dazu hat die betroffene Person volle Kontrolle über ihren Tastsinn, was ihr ein Gefühl von mehr Kontrolle und damit auch mehr Unabhängigkeit geben kann. Es gilt nun noch herauszufinden, welche Informationen für eine bestimmte Person über den Gehör- oder über den Tastsinn vermittelt werden sollen. Genau mit dieser Frage beschäftigt man sich derzeit im Labor von Prof. Murray.

In neurowissenschaftlicher Hinsicht kommt dieser Forschung eine zentrale Bedeutung zu, wenn man verstehen möchte, wie man die Plastizität des Gehirns nutzen kann. Bei diesem Projekt wird das Gehirn mittels bildgebender Verfahren untersucht. Dabei möchte man herausfinden, wie die unterschiedlichen Hirnareale miteinander verbunden sind.

Nächste Schritte

Derzeit testet das Forschungsteam diese Technologie nicht nur in Fahrsimulatoren zwecks Erhöhung der Verkehrssicherheit für sehende Personen, sondern auch innerhalb von Institutionen und Schulen für blinde und sehbehinderte Menschen. In Ergänzung zu den tastbaren 3D-Plänen soll ihnen diese Technologie mehr Unabhängigkeit bei ihrer Fortbewegung geben und auch zu Verbesserungen im Lese- und Geometrieunterricht sowie beim Erfassen von Gegenständen führen. Verlaufen die Tests erfolgreich, könnte diese Technologie bereits in drei Jahren Marktreife erlangen und dann SonderpädagogInnen, Rehabilitationsfachkräften, Angehörigen sowie den blinden und sehbehinderten Menschen selbst zur Verfügung stehen.

Eine erste Validierungsstudie wurde im März in der Fachzeitschrift Frontiers in Integrative Neuroscience veröffentlicht https://www.frontiersin.org/articles/10.3389/fnint.2019.00007/full.